Оценка работы техподдержки с LLM: кейс с компанией из Forbes-2000

Как бизнесу применить LLM для решения конкретной задачи с данными? Это возможно на ValueAI. Рассказываем кейс оценки эффективности техподдержки крупного производителя электроники. ValueAI использовали для обезличивания диалогов и безопасного обращения к ChatGPT, саму LLM для разметки данных, а затем ValueAI для проверки этой разметки и разработки кастомного ИИ. По итогу заказчик смог найти узкие места в процессах, обновил FAQ и в перспективе разработает чат-бота, “заточенного” на частые вопросы.

12 августа 2024

Буквально за полтора года большие языковые модели (LLM) стали одним из самых обсуждаемых инструментов в сфере искусственного интеллекта (ИИ). С их помощью общаются с покупателями, создают контент и даже пишут код. Бизнес, который раньше даже не смотрел в сторону разработки решений с ИИ, видит в больших языковых моделях новую возможность.

Но там, где открываются возможности, рождаются риски. Большие языковые модели — это “черный ящик”: они забывают контекст, отвечают невпопад и в итоге пессимизируют бизнес-процессы. И проблемы LLM лишь наслаиваются на те сложности, которые характерны для любых проектов с ИИ.

Бизнес интересуется потенциалом LLM, но в итоге обнаруживает, что извлечь прибыль из больших языковых моделей не так просто. Чтобы осуществить интересный проект (например, разработать ИИ для оптимизации конкретного процесса), в LLM необходимы серьезные интеллектуальные и финансовые вложения. Для уникального результата потребуются уникальные данные, которые накопил ваш бизнес. Нужны специалисты в области Data Science и промпт-инженеры. Эти люди смогут подготовить данные, позаботиться о приватности и избавить модель от галлюцинаций. Необходимы и те, кто сможет грамотно встроить новый инструмент в вашу инфраструктуру.

Кажется, что при этих условиях проще доверить LLM корректуру ошибок в тексте, чем что-то, имеющее большую бизнес-ценность. Однако появление российских проектов, полноценно использующих LLM, вполне возможно.

Как бизнесу применить LLM для конкретной задачи с данными? Оцениваем эффективность работы техподдержки с помощью LLM

К нам обратился клиент (производственная компания из Forbes-2000), который заходил на российский рынок с новым брендом оборудования для геймеров. Компании необходимо было проанализировать эффективность поддержки пользователей. От качества работы техподдержки зависело то, сможет ли новый бренд надежно закрепиться на рынке. И это были настоящие живые диалоги с вопросами в свободной форме, для оценки которых точно требуется ИИ.

В кейсе, которым мы хотим поделиться, есть все “любимые” челленджи проектов с ИИ:

- Структурировать и обработать алгоритмами живую письменную речь, чтобы создать кастомное решение

- Необычное использование LLM в качестве вспомогательного инструмента для первичной разметки данных, необходимой перед обучением ИИ

- Ожидания по приватности: персональные данные пользователей из РФ нельзя передавать ни в какой сторонний сервис, находящийся за рубежом

- Промпт-инжиниринг

- Возможность интеграции полученной модели в корпоративное ПО

- Не менее амбициозное желание успеть все это за месяц.

Забегая вперед, скажем, что нам удалось решить задачу за счет гибридного подхода: ИИ-платформа ValueAI для обезличивания диалогов и безопасного обращения к ChatGPT, сама LLM для разметки данных, а затем снова ValueAI для проверки этой разметки и уже непосредственно разработки кастомного ИИ. По итогу заказчик смог найти узкие места в своей техподдержке, обновил FAQ на сайте и в перспективе разработает чат-бота, “заточенного” на частые вопросы.

Понимание и применение больших языковых моделей в бизнесе

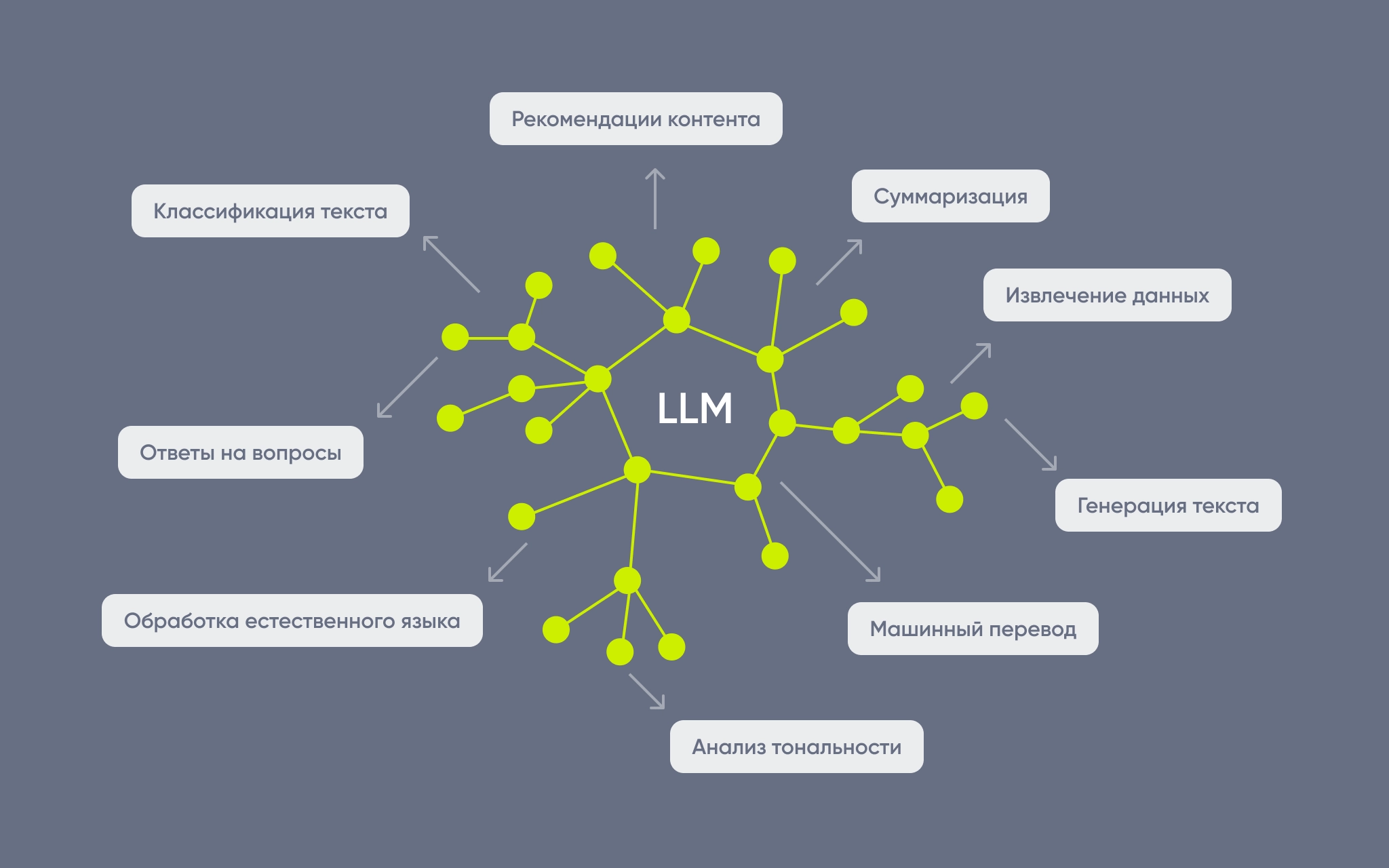

Большая языковая модель (LLM) — огромная нейросеть, которая обрабатывает естественный язык и помогает решать множество задач, связанных с данными и языками. Эти модели могут быть общедоступными и приватными, сложными или более простыми, и их можно использовать для общения в чате через браузер или для обмена запросами через API (хотя такая возможность доступна не у всех моделей). Вдобавок, бывают сети на основе технологий Open Source (например, Claude, LLaMA) и проприетарные, код которых вам недоступен (ChatGPT).

Если ваша задача связана с обработкой естественного языка, вам могут быть полезны создание контента и SEO-оптимизация, рекомендательные системы, ответы на вопросы пользователей живым языком.

В решении этих задач российский бизнес активно использует возможности LLM

В последнее время большие языковые модели начали вытеснять привычные инструменты поиска: Perplexity претендует на места, которые ранее занимали Google и Yandex, а за энциклопедической информацией проще зайти в ChatGPT вместо Википедии. Но и более сложные задачи поручают нейросети: лейблинг информации, прогнозирование трендов, написание кода и легких скриптов. Хотя решение сложных задач через LLM требует опыта и в программировании, и в области машинного обучения.

Препятствия для разработки ИИ и использования LLM “как есть”

Итак, у нашего клиента возникла потребность в разработке инструмента, который бы предоставлял аналитическую информацию на основе текстовых диалогов между технической поддержкой и клиентами.

Что мы хотели:

- Разметить данные клиента при помощи LLM (нейросеть как раз заточена понимать диалоги и извлекать из них суть) — по факту, из естественной речи сформировать сухую и структурированную таблицу

- Размеченные данные использовать для разработки ИИ на платформе ValueAI (предназначенной для узкой целевой работы с данными)

ValueAI — платформенное решение от ИТ-компании «ВейвАксесс» для разработки моделей ИИ, которые обучаются на текстах и данных. Инструмент снижает затраты на разработку и помогает получить контроль над процессом от момента загрузки данных до момента, когда модель уже готова. На проекте именно этот инструмент помог вначале нивелировать недостатки LLM, а затем — использовать результат классификации для быстрого создания своего ИИ, анализирующего работу техподдержки. Все действия с ChatGPT производили через API (из интерфейса ValueAI).

Но ведь классификация данных — буквально одно из основных применений LLM. Зачем делать ИИ в надстройке?

Проблемы с приватностью и персональными данными

Отдав персональные данные в диалоговое окно или через API, обратно вы их не заберете. И хотя Enterprise-версии больших языковых моделей гарантируют, что ваши данные не будут браться в чистом виде, в этом остаются сомнения. Ведь данные — “новая нефть”. Вдобавок, персональные данные россиян защищены законом, который напрямую запрещает загружать их на иностранные площадки.

Отсутствие контроля

Одна из серьезных сложностей при использовании LLM — это проблемы с интерпретируемостью и прозрачностью. Поскольку большие языковые модели представляют собой сложные нейронные сети с миллиардами параметров, понять, почему модель приняла то или иное решение, зачастую бывает крайне сложно. А значит, сложнее исправить возможные ошибки в работе модели.

Ошибки в данных “на выходе”

Нет гарантии, что LLM будет отвечать правдиво или соблюдать консистентность разметки. Чем больше данных, тем выше вероятность, что модель начнет ошибаться, выдумывать новые столбики для таблицы или диалоги, которых не существовало.

Необходимость подготовки и перепроверки качества набора данных

Чем более полный, качественный набор данных у вас будет перед обучением, тем лучше будет результат. Если данных недостаточно или есть ошибки в разметке, то и ответ не попадет в цель. У LLM нет возможности оценить качество данных: она не натренирована угадывать, на каких данных ваш ИИ обучится грамотно, а на каких ничего не выйдет.

Оптимизация последующей работы

После создания модели важно обеспечить удобное использование решения. Необходима интеграция модели в существующие бизнес-процессы и системы.

И финальное наблюдение. Появлению нейросетей предшествовало длительное обучение на корпусах (сборниках) текстов, от научных статей до переписок пользователей на Reddit. Но из-за того, что компании неохотно раскрывают источники обучения, опасаясь исков, настороженность пользователей растет. Порой они реагируют. Например, создание большого количества уязвимого кода и загрузка его на GitHub неизбежно приводит к тому, что нейросеть обучается писать именно такой код.

Гибридный подход для безопасного решения бизнес-задачи: ChatGPT для подготовки данных и ValueAI для всего остального

Поэтому основным инструментом разработки решения была выбрана ValueAI. На этой платформе мы собрали аналитическую модель примерно по тому же принципу, как на Тильде собирают сайт. Кстати, ValueAI — это решение из Реестра отечественного ПО, что позволяет работать с данными пользователей из России.

План разработки мы построили следующий:

- Обезличить данные в ValueAI, чтобы нейросеть не оперировала персональными данными людей, датами, названиями брендов и т.п.

- Управлять нейросетью при помощи промпт-инжиниринга, через промпты, запрещая модели придумывать лишние данные.

- Попросить нейросеть разметить данные для последующего обучения.

- Тема, вопрос клиента, решение службы поддержки, понравилось оно или не понравилось клиенту

- Разработать классификацию, “понять” тональность диалогов и раскидать все по полочкам

- Получить данные в виде, пригодном для построения ИИ-модели (формат таблицы с определенным количеством заполненных столбцов).

- Размеченные данные проверить в ValueAI: убедиться, что данные сбалансированы, размечены правильно и пригодны для обучения.

- Произвести векторизацию, кластеризацию и интерпретацию кластеров (то есть, сами операции машинного обучения).

- Визуализировать результат в графиках.

- Предоставить заказчику API разработанной модели для дальнейшей работы (в итоге интеграцию в их самописную ITSM также делали мы).

Все действия совершали из интерфейса ValueAI, “общаясь” с LLM: у платформы есть интеграция с ChatGPT и LLaMA по API. За счет этого смогли сфокусировать широкие умения LLM на решении конкретных задач клиента.

В итоге получили MVP модели для анализа диалогов. Ретроспективно модель помогла определить наиболее частые вопросы (и добавить их в FAQ), оценить текущую удовлетворенность клиентов опытом общения с поддержкой и оценить эффективность работы сотрудников технической поддержки. В перспективе же модель можно использовать для создания чат-ботов в помощь техподдержке и других задач.

Промежуточный итог. Наиболее и наименее безопасное решение

Напрашивается вопрос: что делать, если мне не так уж важна безопасность? И наоборот: что делать, если моя компания не может позволить себе передачу данных в ChatGPT даже в обезличенном виде из-за очень высоких требований к безопасности?

Действительно, некоторые запросы в ChatGPT можно отправлять напрямую. К примеру, вы хотите быстро и без усилий проверить какую-то гипотезу, но не озабочены комплаенсом. Увы, общение в браузере (или даже через API) означает, что вы буквально дарите ваши данные чужому бизнесу. Однако задачу вы решаете.

Наиболее же безопасный вариант — покупка серверного оборудования, на котором компания в закрытом контуре будет хостить опенсорсную LLM (скажем, LLaMA). Данные будут уходить в нейросеть, но не окажутся в доступе внешних агентов. Разница в затратах, но зато и риски утечек снижены до нуля.

| Ваша ситуация | Ваше решение |

|---|---|

| Запросов немного | Обращение напрямую в ChatGPT |

| Спокойно относитесь к передаче данных в OpenAI или Azure-сервисы | |

| Не требуется сложная интеграция и сертификация (например, для стартапов) | |

| Если стоимость интеграции с API OpenAI дешевле, чем годовая интеграция с ValueAI | |

| Если данные критически важны и их нельзя передавать третьим лицам | Покупка оборудования для хостинга LLM |

| Если нужно сначала проверить гипотезу: протестировать гипотезу в ChatGPT, а на проде уже использовать безопасное решение | Этап тестирования: ChatGPT Прод: Покупка оборудования для хостинга LLM |

| Если планируется очень много запросов, и использование GPT-решений окажется слишком дорогим | Покупка оборудования для хостинга LLM |

Преимущества гибридного подхода к разработке искусственного интеллекта

Итог и что показала практика

Создать MVP бизнес-приложения с искусственным интеллектом за месяц, применяя большие языковые модели, вполне реально. Можно даже начинать проект с проверки гипотезы в ChatGPT, балансируя между обезличиванием или полным закрытием данных внутри компании. Но на наш взгляд, только наличие опытной команды поможет обойти все возможные риски и сэкономить средства.

Платформу ValueAI для задач, связанных с ИИ, можно использовать по-разному:

- Усилить свой продукт мощностями больших языковых моделей (LLM), безопасно обращаясь к ним через интерфейс ValueAI

- Разгрузить свою команду специалистов по машинному обучению через автоматизацию задач с данными

- Использовать алгоритмы платформы без обращения к LLM

Однако наилучших результатов можно добиться вместе с командой. У нас есть значительный опыт работы с LLM, промптинга, разработки ИИ-решений с нуля и управления проектами от идеи до их полного внедрения.

Искусственный интеллект можно разработать разными способами: с нуля или с применением LLM. А с платформой ValueAI и квалифицированной командой «ВейвАксесс» , имеющей более чем 10-летний опыт разработки проектов с машинным обучением, это будет намного проще. Вы сможете не только запустить свой ИИ, но и в полной мере использовать потенциал LLM для решения ваших бизнес-задач.

Свяжитесь с нами для детального обсуждения вашего проекта и записи на демо:hello@valueai.ru

Готовы увидеть ValueAI в действии?

Мы покажем, как ValueAI работает с данными, обучает модель и интегрирует ее в системы

Записаться на демоВам будет интересно

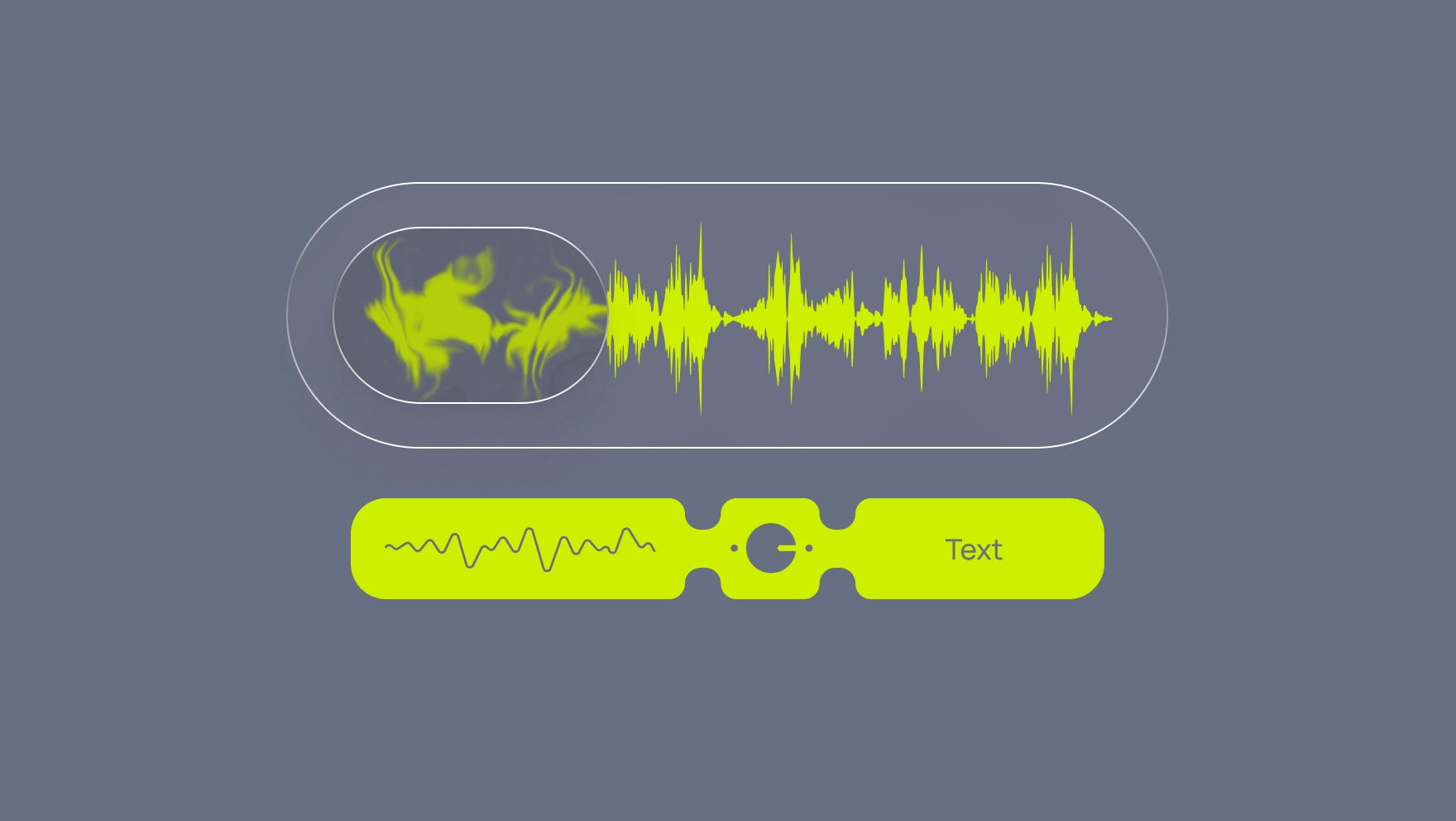

Распознавание речи с ИИ для бизнеса: ValueAI добавил поддержку Yandex SpeechKit и OpenAI Whisper

Как бизнесу извлекать ценную информацию из аудио? ValueAI внедрил поддержку двух Speech-to-Text решений - OpenAI Whisper и Yandex SpeechKit. Теперь компании могут превращать голос в текст, подключать LLM для анализа и автоматизировать процессы на основе аудио данных. В статье - реальные кейсы внедрения ASR технологии.

2 июля 2025

Начните новый ИИ-проект с нами!

Запросите консультацию с нашим техническим экспертом

Сообщение отправлено!

Спасибо за ваш интерес к ValueAI.

Мы свяжемся с вами в течение рабочего дня.

Что-то пошло не так...

Попробуйте, пожалуйста, отправить сообщение еще раз или сообщите нам об ошибке hello@valueai.ru