RAG-поиск по базам знаний

теперь на ValueAI

На ValueAI появился важный функционал работы с базами данным при помощи LLM—интеллектуальный поиск по корпоративным базам знаний на основе RAG (Retrieval Augmented Generation)

14 октября 2024

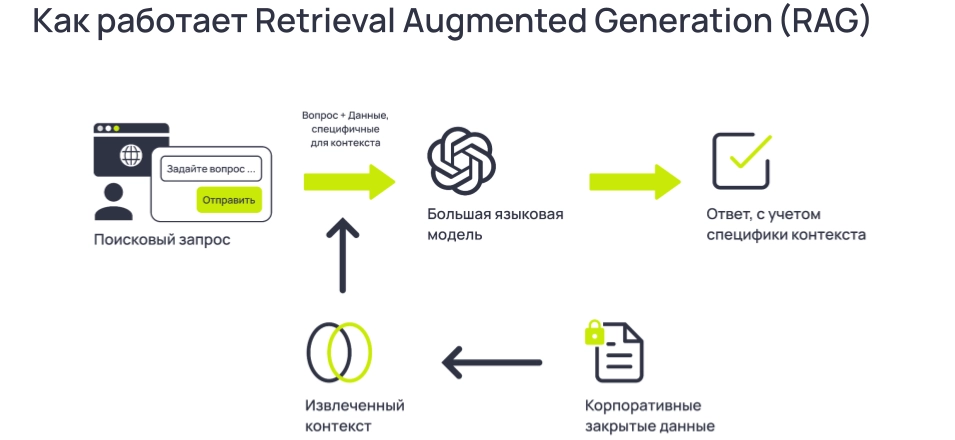

Технология RAG (Retrieval Augmented Generation)сочетает генеративные возможности ИИ с поиском по релевантным источникам информации в реальном времени, позволяя получать надежные и точные ответы. Такой подход сокращает время на анализ данных, минимизирует ошибки, оптимизирует расходы и повышает эффективность коммуникаций. Также доступна возможность использовать ИИ-модели on-premise.

Компаниям, использующим платформу ValueAI для разработки и внедрения искусственного интеллекта, стала доступна функция RAG, или генерации с дополнительной выборкой. С ее помощью пользователи могут в режиме реального времени получать точные и релевантные ответы на типовые вопросы из любой внутренней базы знаний: объемной документации, в которой сложно ориентироваться (инструкции, регламенты и др.). Интеграция с уникальными и надежными источниками информации, доступными только для организации, позволяет ИИ-модели опираться на реальные данные, что значительно уменьшает вероятность выдачи вымышленных ответов и минимизирует риск ошибок.

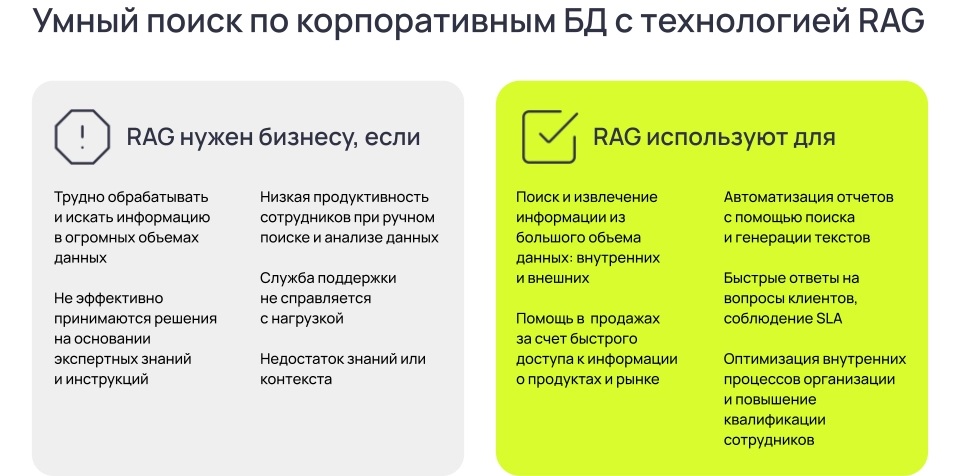

Когда компаниям нужен RAG-поиск и для чего

Платформа ValueAI выступает как готовый инструмент для RAG-поиска, который объединяет базу знаний, загруженную через интерфейс или интегрированную по API, преобразование файлов в подходящий для поиска формат, поиск релевантной информации, ее обработку ИИ-моделью и генерацию ответа чат-ботом.

Как работает RAG-поиск по БД

Для интерпретации найденной информации RAG-модуль в ValueAI использует одну из больших языковых моделей YandexGPT, ChatGPT или LlaMA. Также доступна возможность использовать модели on-premise.

Модуль также можно настроить, чтобы он самостоятельно обращался ко внешним обновляемым корпоративным системам для автоматического пополнения базы новыми записями, а также адаптировать его для работы со специализированными предметными областями, требующими глубокого контекстуального понимания.

«Поиск с RAG значительно улучшает работу служб поддержки, контакт-центров и HR-департаментов. Мы наблюдаем особый интерес к этой функции со стороны бизнеса, работающего с большими объемами информации, в частности госучреждений, производства, юридических компаний, фармацевтики, финтеха и строительства. Также RAG-поиск востребован среди организаций с высокой текучкой кадров или, наоборот, интенсивно наращивающих штат, и крупных компаний с развернутой службой поддержки клиентов»

Команда «ВейвАксесс» создала платформу ValueAI, чтобы компании могли извлекать ценность из своих данных, строить прогнозные модели под свои задачи и оптимизировать работу команд, прибыль и качество услуг с помощью ИИ.

Больше информации по возможностям использования RAG-поиска по вашим базам данных на платформе ValueAI вы узнаете на Демо. Свяжитесь с нами для детального обсуждения вашего проекта. Мы ждем вас!

Готовы увидеть ValueAI в действии?

Мы покажем, как ValueAI работает с данными, обучает модель и интегрирует ее в системы

Записаться на демоВам будет интересно

Распознавание речи с ИИ для бизнеса: ValueAI добавил поддержку Yandex SpeechKit и OpenAI Whisper

Как бизнесу извлекать ценную информацию из аудио? ValueAI внедрил поддержку двух Speech-to-Text решений - OpenAI Whisper и Yandex SpeechKit. Теперь компании могут превращать голос в текст, подключать LLM для анализа и автоматизировать процессы на основе аудио данных. В статье - реальные кейсы внедрения ASR технологии.

2 июля 2025

Начните новый ИИ-проект с нами!

Запросите консультацию с нашим техническим экспертом

Сообщение отправлено!

Спасибо за ваш интерес к ValueAI.

Мы свяжемся с вами в течение рабочего дня.

Что-то пошло не так...

Попробуйте, пожалуйста, отправить сообщение еще раз или сообщите нам об ошибке hello@valueai.ru